Inteligência artificial está mais para ferramenta de criminosos que redentora das ciências.

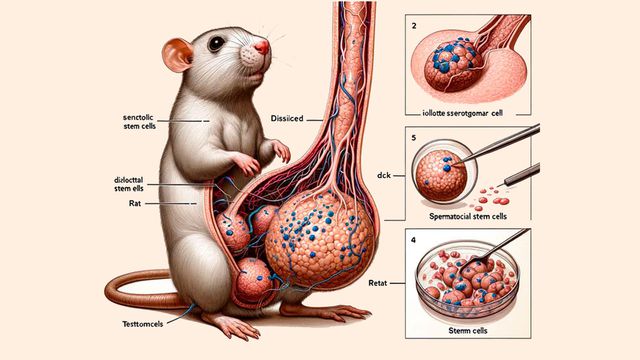

Na última semana, um acontecimento inusitado balançou a ciência — uma revista científica publicou uma pesquisa revisada por pares contendo diversas imagens geradas por inteligência artificial (IA), com pouco critério pelo realismo necessário. As bizarras imagens geradas incluem um rato com um pênis anormalmente grande, o que chamou a atenção nas redes sociais.

O periódico em questão foi a Frontiers, em sua divisão Cell Development and Biology, e o estudo é bastante específico e de nome complicado: “Funções celulares das células-tronco espermatogoniais em relação à via de sinalização JAK/STAT” , em tradução livre. Poucas pessoas fora do nicho científico se interessariam pelo tema, que chamou a atenção devido à natureza das imagens.

Os responsáveis pelo estudo são cientistas da Universidade Jiaotong e do Hospital Hong Hui, ambos na China. Após a repercussão do artigo e alvoroço da comunidade científica, que considerou o uso indiscriminado de ferramentas de IA como nocivo ao mundo acadêmico, os editores da revista Frontiers retiraram a publicação na última quinta-feira (15), ficando apenas dois dias no ar.

O artigo em si trata de temas importantes, vale dizer — os cientistas estudaram as espermatogônias, células que se tornarão espermatozoides, mais especificamente as células-tronco relacionadas a elas e os caminhos que as proteínas usam para isso. Isso é importante para a medicina regenerativa, regulação do sistema imune e engenharia celular, tendo relação com terapias adjuvantes, ou seja, que ajudam pacientes a ter uma sobrevida melhor após tratamentos de saúde.

IA generativa e os erros do estudo

A imagem de maior destaque no incidente é a do rato em corte vertical, que, além dos genitais desproporcionais, têm a dissecação de seus outros órgãos fora de proporção. Fora as atrocidades anatômicas que a IA cometeu, com tecidos e células sem precisão biológica, também há textos que lembram vagamente termos científicos, mas não querem dizer nada, como “testtomcels”, “iollote sserotgomar cell”, “retat”, “dissilced” e “dck”.

Além do exagero na ilustração do roedor, representações de recortes de células presentes no restante do artigo são igualmente desprovidas de sentido, cheias de textos truncados gerados automaticamente e com aberrações típicas do exagero cometido pelas IAs. Isso inclui excesso de elementos e um aspecto visual que lembra mais uma criatura alienígena (ou uma pizza, nas palavras da revista Vice) do que algo animal.

Por falar na Vice, sua divisão Motherboard entrou em contato com os responsáveis pela revisão do artigo para descobrir o que teria acontecido. Jingbo Dai, da Universidade Northwestern, nos EUA, revisou o estudo e afirmou que checou apenas os dados científicos brutos, não tendo responsabilidade pelas imagens — cientificamente, o conteúdo estava correto.

Segundo o cientista, a editora responsável pela Frontiers é que deve explicações por outros detalhes, como as imagens. Um segundo revisor, baseado na Índia, não quis comentar o caso. Os responsáveis pelo estudo creditaram a ferramenta Midjourney em seu trabalho, e a Frontiers afirmou que o uso de IA é permitido, contanto que a precisão factual seja garantida pelos autores.

Inteligência artificial na ciência

A adaptação da ciência ao uso de IA está passando por diversos percalços — ano passado, a revista Nature baniu o uso de IAs generativas como um todo, por exemplo. Mas isso não quer dizer que inteligências artificiais, no geral, sejam puramente vilãs. A tecnologia ajuda muito no processamento de dados, buscando informações com maior rapidez e navegando por amontoados de informações para detectar padrões muito melhor do que humanos conseguiriam, por exemplo.

A grande questão é o uso de IA generativa, que, como o nome sugere, “cria” imagens, textos e conteúdos no geral. Isso não é tirado do nada — a IA só consegue elaborar coisas a partir do que humanos criaram, o que pode, por exemplo, acabar reforçando preconceitos estruturais, como mostrar grupos étnicos como “pobres” de acordo com nossos vieses.

Chatbots como o ChatGPT e geradores de imagem como o Midjourney podem “alucinar” muito, tornando seu uso perigoso em veículos oficiais, como os científicos (Imagem: Matheus Bertelli/Pexels)

Em algumas situações, a IA pode acabar simplesmente gerando resultados enganosos, como quando, no estudo aqui descrito, exagerou nas proporções anatômicas e incluiu figuras que parecem células e tecidos, mas são apenas recriações de ilustrações humanas sem precisão ou contexto suficiente. Isso para não citar as palavras, a exemplo de “immouminomuduodiulatiuciaton”, que deve ter surgido de “immunomodulation”, ou imunomodulação, em português.

IAs alucinadas

Há um nome para isso, aliás — chamamos o fato de “alucinação”, que ocorre quando a IA não encontra a resposta necessária e cria algo fantasioso em cima do que consegue juntar de informação.

Isso só prova que, apesar dos avanços, o uso de inteligência artificial, especialmente a generativa, precisa de cuidados, ainda mais quando falamos da ciência, que impacta a vida e saúde de seres humanos. A Nature citou preocupações com a integridade das informações ao banir as IAs generativas em suas publicações, e é possível que levemos alguns anos para que isso seja atingido.

Leia aqui

Fonte: Frontiers, Nature com informações da Vice

[Voltar]